エンジニアが重要なパッチを誤抜去、Cloudflareが停止

現地エンジニアが2か所の基幹 データセンター の内の1か所で、複数の冗長光ファイバ回線を抜去した事が原因で、Cloudflare(クラウドフレア)で大規模な障害・停止が発生しました。 この事故は、計画メンテナンス中に発生し、同社はその原因を、エンジニアではなく、乱雑な作業指示、及び不十分なケーブルラベルによるものだったとしています。

Cloud flare-up(クラウド炎上)

「当社のコアデータセンターの1つで、計画メンテナンスの一環で、ある1ラックの全機器の撤去を現地エンジニアに指示した。」と同社のCTO John Graham-Cumming氏はブログに投稿しています。

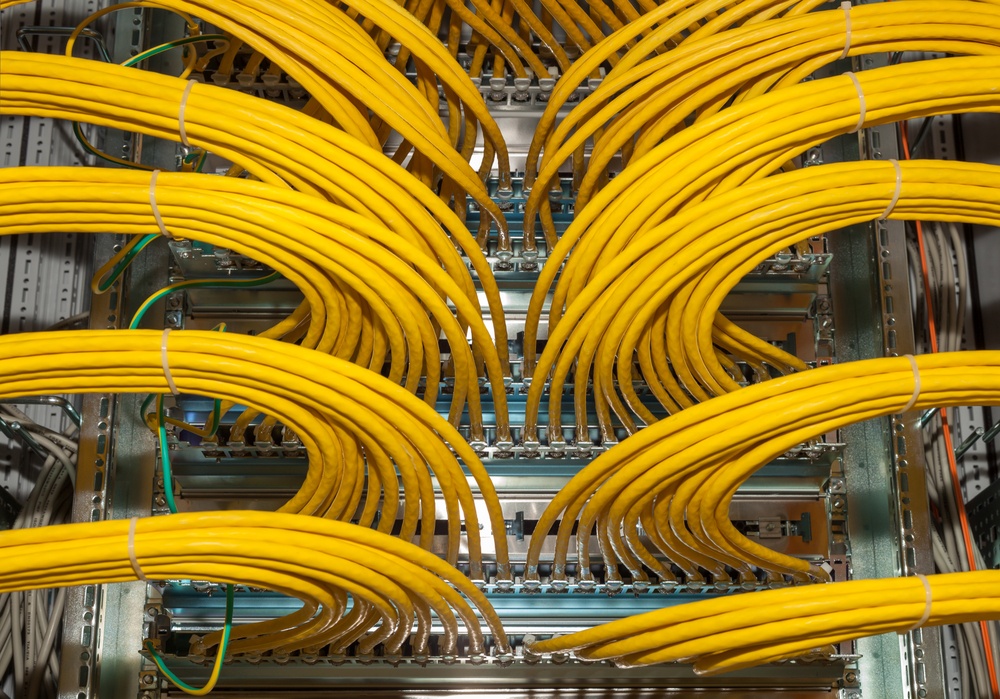

「そのラックには、撤去予定の古い非稼働機器が設置されており、ラック内には、どのサーバも使用中の回線やデータは無かったが、他のCloudflareデータセンターへ外部接続されている パッチパネル が設置されていた。 3分の間で、 エンジニアは未使用の機器を撤去し、このパッチパネルからケーブルを抜いてしまった。」

その結果、ネットワークは正常稼働を維持していたものの、CloudflareダッシュボードとAPIは15:31 UTCから19:52 UTCの間利用できなくなりました。

Graham-Cumming氏は、外部接続用のケーブルを識別するのに時間が必要で、必要以上にサービス復旧までの時間がかかったことを認め、 「ケーブルとパネルにラベルを貼り付け、障害対応時にエンジニアが誰でもすぐに判別できるような対策を施す。」と述べました。

同社は今後、ラベリング関連の改善と共に、触れてはいけない回線のケーブルについて、エンジニアへの明確な通知をすることを予定しています。

Graham-Cumming氏は、次のようにも述べています。「多様な事業者との外部接続は、多様なデータセンターに接続されていたが、我々は全回線を1つのパッチパネルに収容していた、それで単一の物理的障害点を作ってしまった。このことは、自社内のあらゆる施設の部門にも伝えるべきだ。」

サービス復旧に取り組む「War Room(ウォールーム)」のチームが、新型コロナウイルス感染症(Covid-19)の理由もあり、各自自宅からリモートで作業をする必要があったことも、事態を悪化させたと考えられます。

Cloudflareは昨年、本件とは関係のない原因による、2件の大きな障害を引き起こしていました。1つは BGP エラー、もう1つは内部の DDoS 保護システムの問題によるものでした。

同社は2012年に起きた最初の障害(ハッキング)も含み、異常にオープンになっています。「信じられないほど苦痛だった。」とCEOのMatthew Prince氏は当時DCDに語っていました。

「それは我々の一顧客に影響を与えた、そして、私自身にも影響をもたらした。ハッカーが侵入する為に、私の個人メールをハッキングしたのです。」

「率直に言うと、私は恥ずかしく感じた。私は起こった全ての詳細を共有したくはなかった。チームは言っていた。『いいえ、これは私たちの文化ではない。それは我々を表しているものではない。我々は何が起こっても、根本的に透明性を持つことを理念においている。』顧客を失うのではないかと心配だった。しかし代わりに、透明性が実際に人々の信頼を築くのに役立つことがわかったのです。」

Data Center Dynamics

コメント ( 0 )

トラックバックは利用できません。

この記事へのコメントはありません。