Google、最新チップに液冷採用- 自社データセンターの高密度化で

毎年新たなTPU

Googleは、年次開発者会議にて、最新世代のテンソル・プロセッシング・ユニット( TPU 3.0)を公開しました。

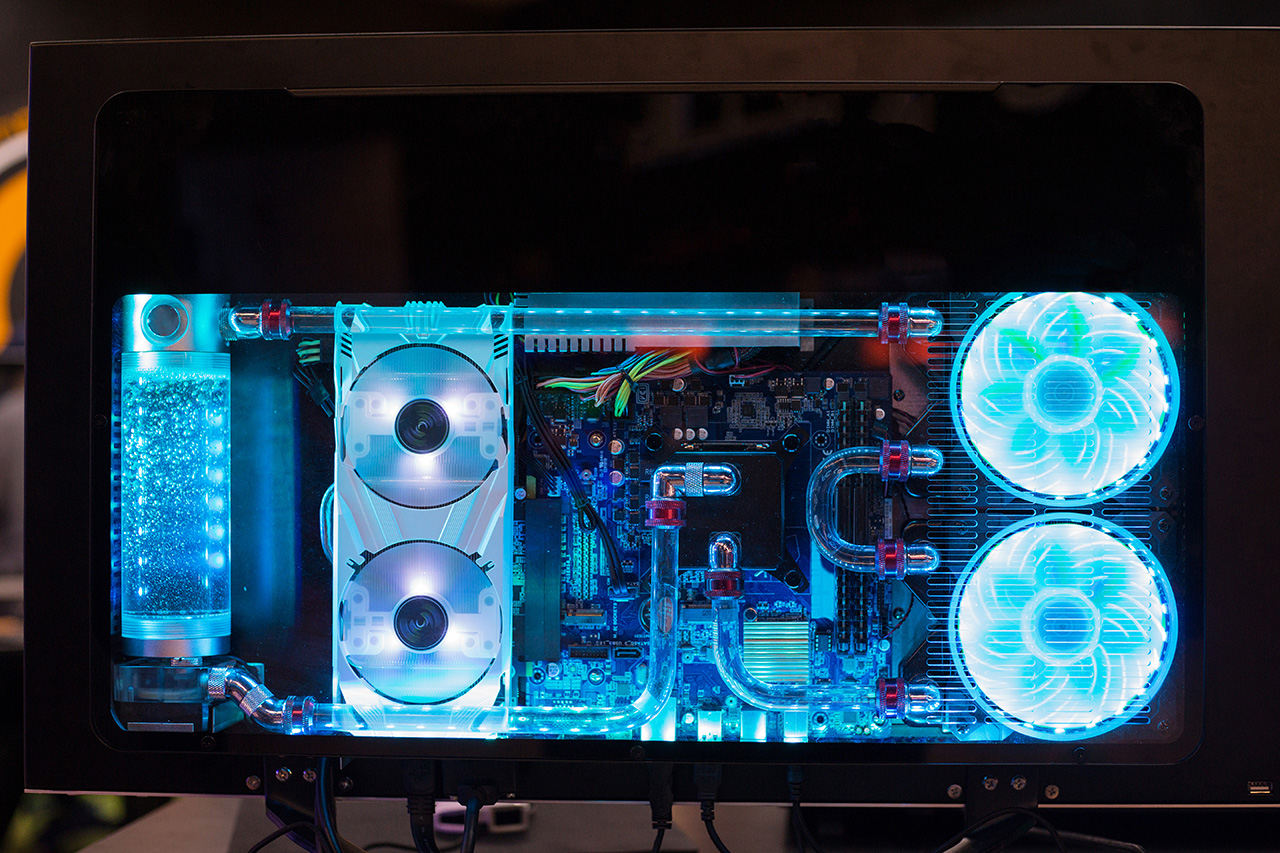

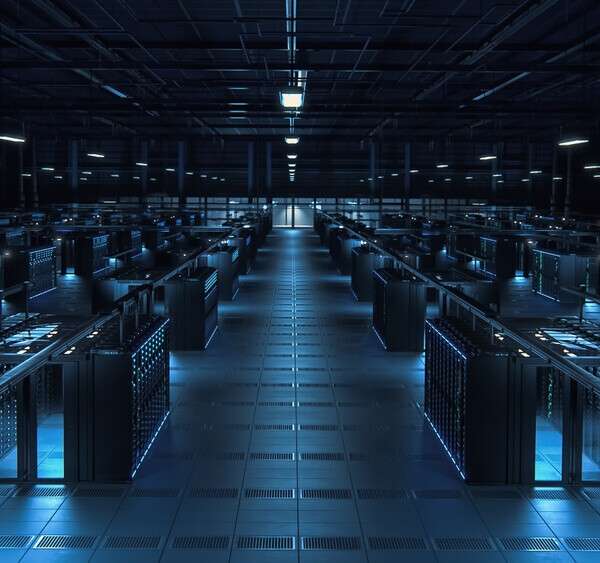

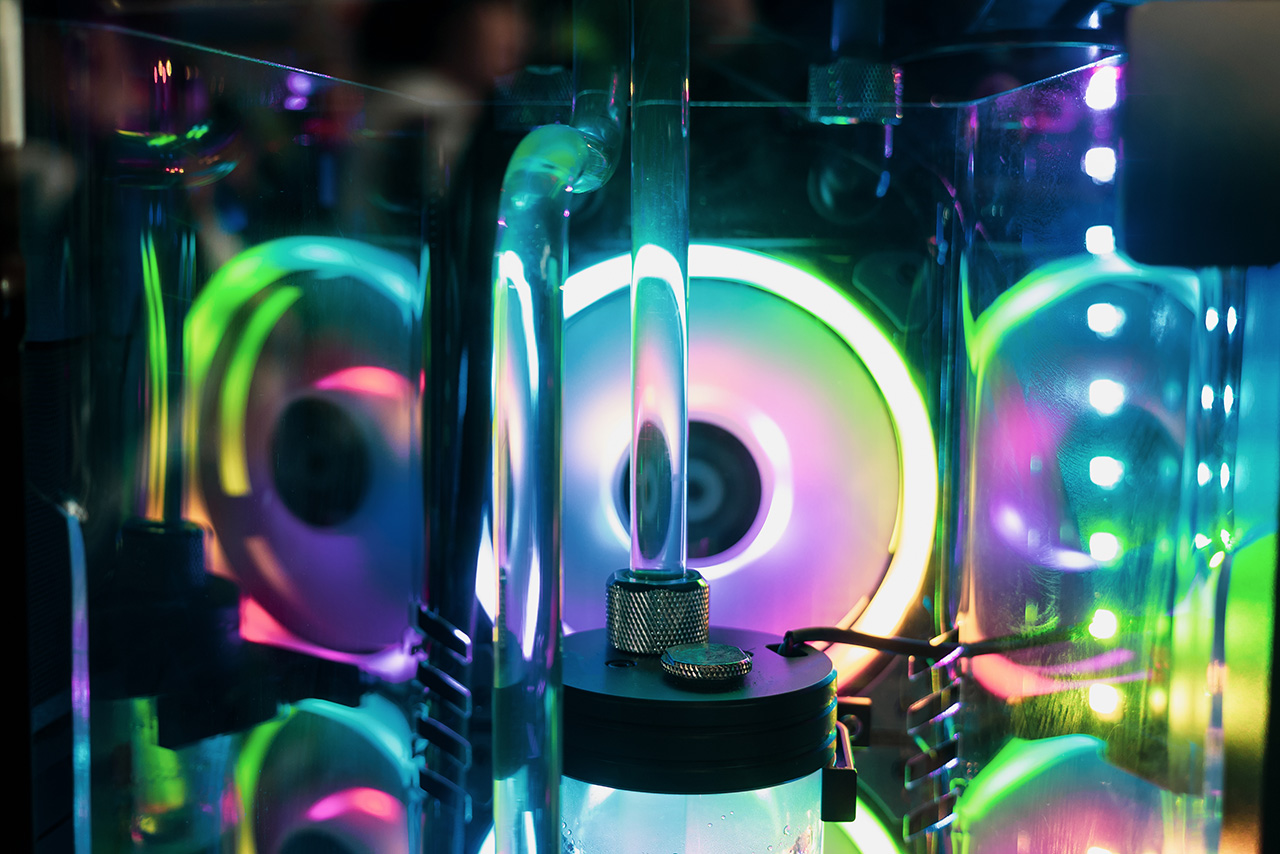

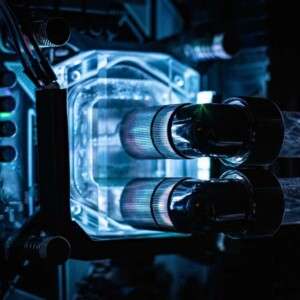

高密度ハードウェア、高密度サーバーの冷却のため、特定用途向け集積回路(ASIC)には液冷を採用しました。これは、世界最大の検索・広告企業Googleとしては初めてのことです。数ヶ月以内に同社は大規模な展開を始めることになるでしょう。

熱を感じる

「チップがとてもパワフルなので、我々は初めてデータセンターに液冷を導入せざるを得ませんでした」と語るのはGoogleのS.ピチャイCEOです。

「そして、我が社はこれらのチップを巨大ポッドという形で設置しました。今回のポッドは昨年のTPUよりも8倍強力で、100ペタフロップスを優に超えます。これこそ我々がより良質で、より大規模で、より正確なモデルを開発することを可能にし、さらなる課題への取り組みにとって手助けとなるでしょう」

しかし、Googleは100ペタフロップスというパフォーマンスを獲得するためのベンチマークを明らかにはしませんでした。元来のTPUは、利用されうるアプリケーションの幅がかなり限定されており、分岐命令のサポートもなく、そして主に機械学習の推測タスクに適用されていました。TPU2.0は、8つのラックポッドに64のチップを搭載、最大11.5ペタフロップスの能力をもって、機械学習のトレーニングと実行をサポートしました。

「しばらくの間、我々はコンピューターの構造分野に対して大規模投資を行ってきました」とピチャイ氏は述べました。「TPU2.0は、今日目の当たりにしているあらゆる製品の向上をもたらし、Googleのクラウドユーザーにも利用できるようにしたのです」

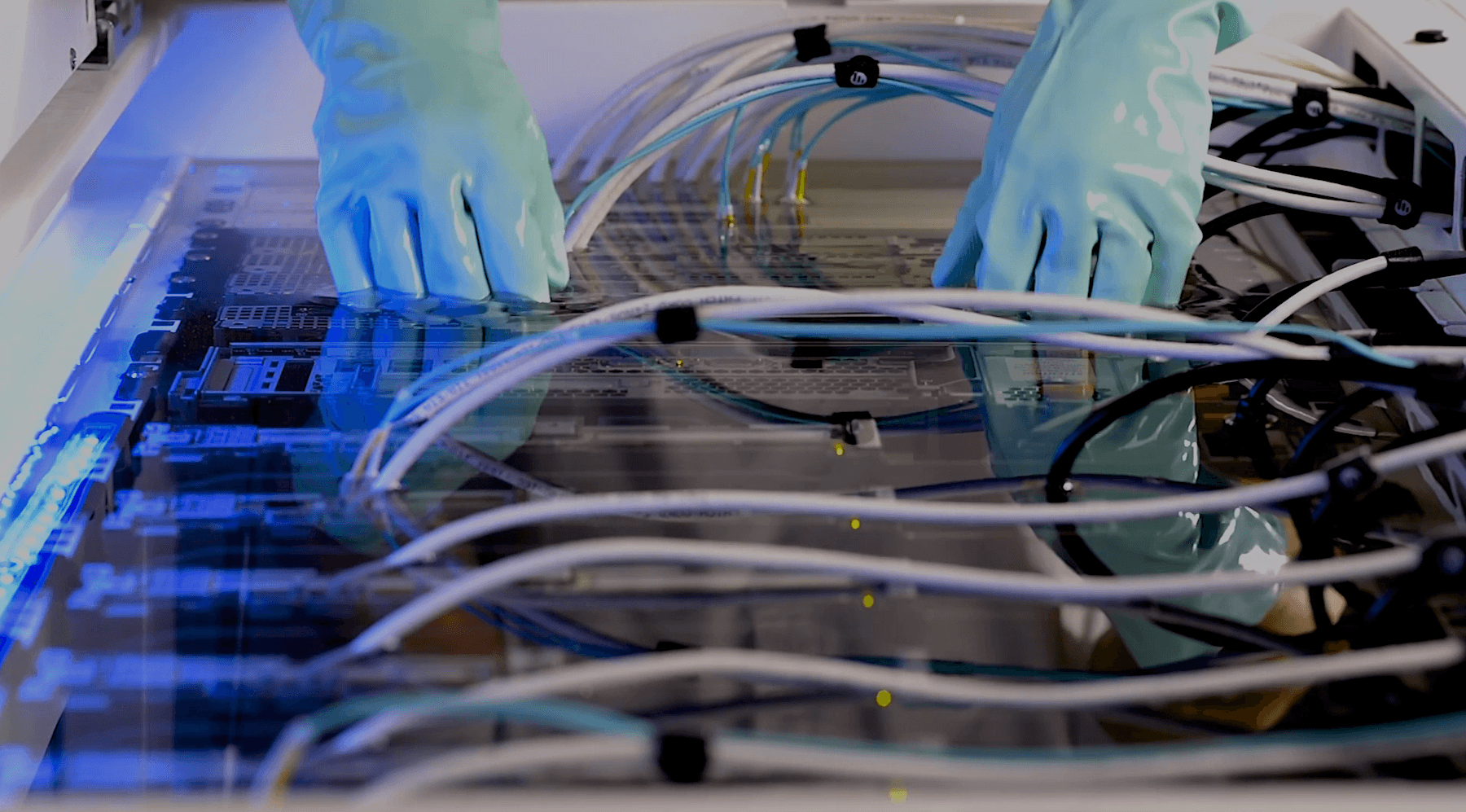

各TPU3.0は128GBの高帯域幅のメモリを有し、それはTPU2.0の2倍にあたります。さらなる構造の仕様については公表されませんでした。液冷のプロセスのより明確な詳細についても同じく不明です。

TPUマザーボードのイメージ図には、チップに直付けの液冷が表示されています。各ボードに4つのチップを搭載し、各ASIC上の銅製の コールドプレート には冷却液が行きわたっています。

AI や機械学習のワークロードがますます重要になるにつれて、高密度ラックの人気がより高まっています。そのようなラックが生み出す大量の熱を処理する液冷ソリューションもそのひとつです。

-Data Center Dynamics

– 原文はこちら

コメント ( 0 )

トラックバックは利用できません。

この記事へのコメントはありません。