Google、Cloud TPUのベータ版を提供開始

第2世代社内チップの導入から1年

Googleはベータ版ではありますが、ついにGoogleクラウドプラットフォーム上で第2世代のテンソル処理ユニット( TPU )の提供を開始しました。

TPUは、Google独自の AI アクセラレータを備えた特定用途向け集積回路( ASIC )です。 TensorFlow フレームワークでプログラムされた機械学習ワークロードを高速化するために設計されました。

2015年に自社データセンターでTPUを使用開始しているGoogleは、昨年第2世代モデルを発表しました。当時、Googleはクラウドサービスの一環として社内推論チップを導入する計画を立てていたと述べていましたが、この計画が完了するまでに、ほぼ1年かかりました。

TPUポッドは様子見

GoogleクラウドのCloud TPUのプロダクトマネージャであるJ.バラス氏とGoogleブレインチームでTensorFlowならびにCloud TPUのプロダクトマネージャであるZ.ストーン氏のブログ記事によると、TPU2は最大180テラフロップの浮動小数点パフォーマンスと64GBの高帯域幅メモリを提供します。

このサービスによって、ユーザーはより速く、より独立した作業を行うことができると両氏は断言しています。「ユーザーはジョブが共有コンピューティングクラスタでスケジュールされるのを待つのを止めて、自分で思う通りに操作できるGoogle Compute Engine VMを通して、ネットワークに接続しているCloud TPUにインタラクティブ、かつ、排他的にアクセスできます。ビジネスクリティカルな機会学習モデルをトレーニングするのに数日から数週間かけるのではなく、同じモデルのいくつかのバリエーションをCloud TPUで一晩トレーニングすれば、翌日には最も正確にトレーニングされたモデルを運用環境で展開することができます。」

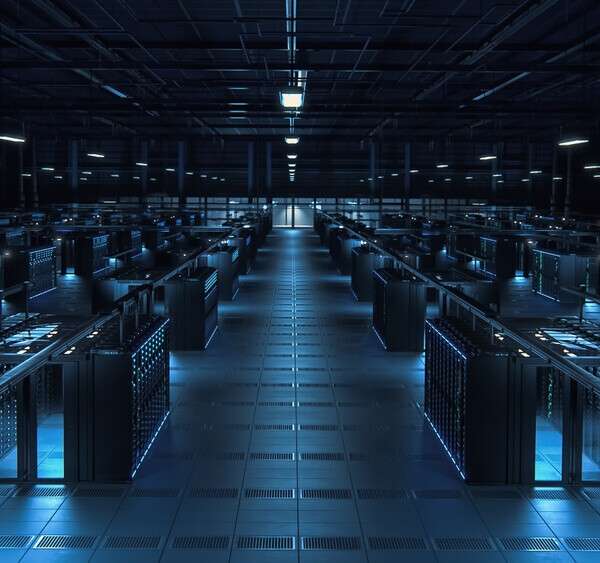

このブログでは、Cloud TPUを使用することで、電力、冷却、ネットワーク、およびストレージ等に関する特別な要件をクリアしたオンサイト機械学習コンピューティングクラスタの設計や、インストール、および維持に必要な資本、時間、専門知識を低コストで代替できる、とも書かれています。

最終的には、この新しいTPUによって、カスタムASICをプログラミングするプロセスがよりシンプルになると述べています。オープンソース・モデルでプログラミングできるからです。「リファレンス・ハイパフォーマンスCloud TPUモデルの実装をオープンソース化し、ユーザーがすぐに使えるようにしました:画像分類のためのResNet-50および他の一般的なモデル、機械翻訳および言語モデリング向けTransformer、オブジェクト検出のためのRetinaNet等です。

これらのチップは相互リンクが可能で、GoogleがTPUポッドと呼ぶ最大64個のTPUを持つスーパーコンピュータに似たネットワークを構築します。

今のところ、Cloud TPUは、限定的な利用性、価格はTPUあたり6.50ドル/時間、ポッド付きで、今年後半には提供開始の予定です。

– Data Center Dynamics

– 原文はこちら

コメント ( 0 )

トラックバックは利用できません。

この記事へのコメントはありません。