マイクロソフト、自社製Arm CPUとAIアクセラレータチップ、カスタムラックを発表

マイクロソフトは、Arm CPUと専用のAIアクセラレータという2つの自社設計半導体製品を発表しました。

「Microsoft Azure Cobalt」 CPUは、一般的なワークロード向けに設計されており、ワットあたりのパフォーマンスに重点を置いています。一方、「Microsoft Azure Maia」 AIアクセラレータは、AIタスクや 生成AI向けに最適化されています。

同社は、このチップのデータセンターへの展開を来年初めに開始し、最初はMicrosoft CopilotやAzure OpenAI Serviceなどの内部サービス向けに展開すると話しています。その後、より一般的にMicrosoft Azureで利用できるようになる予定だが、個別に販売される可能性は低いとみられています。

マイクロソフトのクラウド&AIグループのEVPであるScott Guthrie氏は、「マイクロソフトはAIイノベーションをサポートするインフラを構築しており、顧客のニーズを満たすためにデータセンターのあらゆる面を再構築している」と述べています。

「我々が運営する規模では、パフォーマンスを最大化し、サプライチェーンを多様化し、顧客にインフラの選択肢を提供するために、インフラスタックのあらゆるレイヤーを最適化し、統合することが重要である」

Azure Cobalt 100 CPUは、Microsoft Azure上で競合のArmチップAmpereに加わることになります。現在、Azure Cobalt 100は、Azure SQLサーバーやMicrosoft Teamsといったマイクロソフトの自社製品に使用されています。また、Armv9の128 Neoverse N2コアと12チャンネルのDDR5を搭載し、ArmのNeoverse Genesis CSS(Compute Subsystem)プラットフォームをベースにしています。

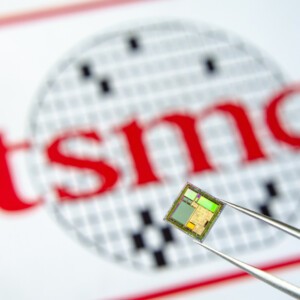

Maiaに関しては、TSMCの5nmノードで製造され、モノリシックダイ上に1050億トランジスタを搭載しています。MXInt8の性能は1,600Tflops、MXFP4の性能は3,200Tflopsで、これはGoogleのTPUv5やAmazonのTrainiumに匹敵すると謳っています。

Maiaに関しては、TSMCの5nmノードで製造され、モノリシックダイ上に1050億トランジスタを搭載しています。MXInt8の性能は1,600Tflops、MXFP4の性能は3,200Tflopsで、これはGoogleのTPUv5やAmazonのTrainiumに匹敵すると謳っています。

メモリ帯域幅は1.6TBpsで、Trainiumを上回りますが、TPUv5よりは劣ります。

SemiAnalysisのレポートによると、このチップはカスタム設計のラックとAresと呼ばれるクラスタ内に配置される模様です。なおこのサーバは標準的な19インチや OCPとは異なり、”はるかに広い “と報告されています。

Aresは液冷構成としてのみ利用可能で、一部のデータセンターでは水冷式CDUを導入する必要があります。

マイクロソフトによると、各ラックには「サイドキック」があり、冷却インフラがシステムの側面に配置され、コールドプレートに液体を循環させるといいます。

各サーバには4基のMaiaアクセラレータが搭載され、1ラックあたり8台のサーバが搭載さ れます。

マイクロソフトは、「OpenAIはAzure Maiaに関するフィードバックを提供し、それが将来のマイクロソフトの設計に役立つだろう」と述べています。

OpenAIのCEOであるSam Altman氏は次のように述べています。「マイクロソフトとの最初の提携以来、私たちはAzureのAIインフラストラクチャを、私たちのモデルやこれまでにないトレーニングのニーズに合わせて、あらゆるレイヤにおいて共同で設計してきた」

「マイクロソフトが初めてMaiaチップの設計を共有したときには興奮し、我々は協力してそれを改良し、当社のモデルでテストしてきた。AzureのエンドツーエンドのAIアーキテクチャは、Maiaによってシリコンまで最適化され、より高性能なモデルをトレーニングし、そのモデルを顧客にとってより安価なものにする道を開いている」

しかし、同社(OpenAI)は、異なるチップ設計(大規模言語モデルのトレーニングの鍵となる、より高いメモリ帯域幅を持つ可能性が高い)への要望から、独自のチップの開発を検討していると報じられています。

マイクロソフトは現在、両チップの第2世代バージョンの開発を進めています。

この記事は海外Data Centre Dynamics発の記事をData Center Cafeが日本向けに抄訳したものです

コメント ( 0 )

トラックバックは利用できません。

この記事へのコメントはありません。