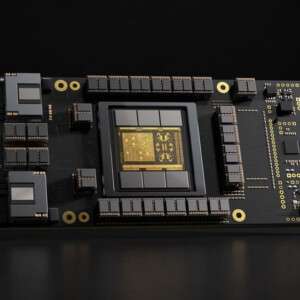

Nvidia、大規模言語モデルおよび生成AIワークロード向けGPU「H100 NVL」を発表

Nvidiaは、大規模な言語モデルや生成AI(ジェネレーティブAI)の開発に特化したバージョンのH100 GPUを開発したと発表しました。

デュアルGPUの「H100 NVL」は、H100 SXMやPCIeよりも多くのメモリを搭載し、大規模AIモデルにとって重要な機能であるメモリ帯域の拡張も実現しています。

既存のH100は80GBのメモリー(SXMはHBM3、PCIeはHBM2e)を搭載しています。H100 NVLでは、2つのGPUにそれぞれ94GBのHBM3メモリが搭載され、合計188GBとなっています。

また、メモリ帯域幅はGPUあたり3.9TBpsで、合わせて7.8TBpsとなります。ちなみに、H100 PCIeは2TBps、H100 SXMは3.35TBpsです。なお、この新製品は、上部にNVLinkコネクタを3基搭載しています。

Nvidiaは、OpenAIがGPT-3の開発に使用したA100 GPUと比較して、最大12倍の推論性能を実現するとしています。

Nvidiaのハイパースケール/HPC担当VPのIan Buck氏は次のように述べています。「この素晴らしいGPUは、GPTベースの大規模言語モデルで推論を走らせ実行するための総所有コスト(TCO)をかなり低減します。これは、GPTと大規模言語モデルを広く普及させる上で、重要な役割を果たすでしょう」

この記事は海外Data Centre Dynamics発の記事をData Center Cafeが日本向けに抄訳したものです。

コメント ( 0 )

トラックバックは利用できません。

この記事へのコメントはありません。