Nvidia、新しいソフトウェア・ライブラリでH100 GPUのLLM推論速度が2倍になると主張

オープンソースのTensorRT-LLMを来月リリース、生成AIワークロードをターゲットに

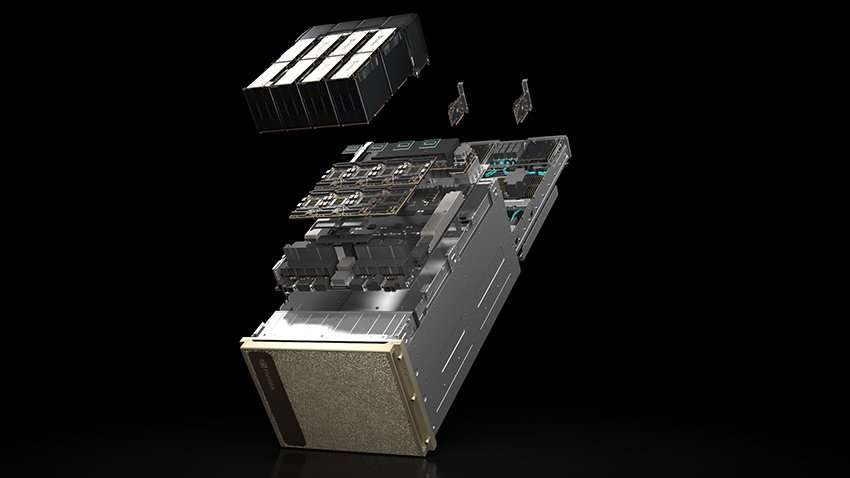

Nvidiaは、H100 GPU上での大規模言語モデル(LLM)の推論速度を2倍にすると主張するオープンソースのソフトウェアライブラリ「TensorRT-LLM」をリリースする計画を進めています。

TensorRT-LLMは来月上旬、Nvidia AI Enterpriseソフトウェアスイートの一部として、NvidiaのNeMo LLMフレームワークに統合されます。これは現在、早期アクセス版として提供されています。

NvidiaのハイパースケールおよびHPC担当副社長であるIan Buck氏は、「最新の技術、最新のスケジューラを使用し、さらに最新の最適化とカーネルを組み込むことで、性能を2倍に向上させた」と述べています。

NvidiaのハイパースケールおよびHPC担当副社長であるIan Buck氏は、「最新の技術、最新のスケジューラを使用し、さらに最新の最適化とカーネルを組み込むことで、性能を2倍に向上させた」と述べています。

「これらの技術は、単に効率を上げるだけでなく、アルゴリズムをエンド・ツー・エンドで最適化することで、パフォーマンスを向上させるものである」

TensorRT-LLMは、A100、L4、L40、L40S、そして近日発売予定のGrace Hopper Superchip(Grace CPUとH100を組み合わせたもの)を含む、他のNvidia GPUもサポートする予定です。

このソフトウェア・ライブラリには、新しい「In-Flightバッチング」スケジューラが含まれており、他のタスクから独立してGPUに入ったり出たりすることができます。このライブラリはまた、自動FP8変換、カーネル・フュージョン用DLコンパイラ、混合精度オプティマイザなども提供します。

この記事は海外Data Centre Dynamics発の記事をData Center Cafeが日本向けに抄訳したものです。

コメント ( 0 )

トラックバックは利用できません。

この記事へのコメントはありません。