進化するデータセンターのハードウェアや物理設計【特集】

液冷

過去数十年間、液体冷却は大きな可能性を示してきました。液体は、空気よりも熱を捉えて除去する能力ははるかに高いが、液体をラック内のハードウェアに利用することは、既存の慣行に対しては大きな変化を求めます。そのため、液体冷却は風変わりな技術の一例として残っています。しかし実際には余分なコストや頭を悩ます理由はありません。

ラックあたり20 kW未満の場合、空冷方式はコスト効率が高く、特にラック内に液体を持ち込む必要はありません。 一般の環境での電力密度はこの数値をはるかに下回っているため、ほとんどのデータセンターでは水冷無しでも簡単に構築ができます。ただし、液体冷却方式を前面に押し出す2つの可能性があります。

まず、GPUやAIなどの特殊なハードウェアが、電力密度を向上させつつあるという背景があります。

次に、液体冷却を実装した場合の利点があげられます。いったん実装されると、液体冷却は施設に多くの柔軟性をもたらします。空冷ラックの場合、ビル全体の壁や床まで、空調機やコンテイメントなどをシステムの一部として考えなければなりません。

一方、水冷ラックは、つなぎ目が必要なだけで、セメント床、カーペット敷きのスペース、または小さなキャビネット内など個別に設置が可能です。

液体は、IT機器に影響を与えるため、コロケーションスペースでの利用は難しいケースがあります。したがい、顧客が特に液体冷却を必要としない限り、通常は利用されません。ただし、プロバイダーがハードウェアを制御し、建物レベルのコンテイメントシステムが存在しないデータセンターでは、柔軟性の向上に役立ちます。

小規模のエッジ施設は、多くの場合、完全なデータセンターのリソースを持たないマイクロデータセンターです。あるいは、再利用された建物内に少しずつ追加しつつ構築されたりしています。液体冷却システムは、このような施設の要件には十分に適合することができます。

実は初期のメインフレームは水冷式でしたが、現代ではさまざまなメーカーから新しい液体冷却製品が登場してきています。

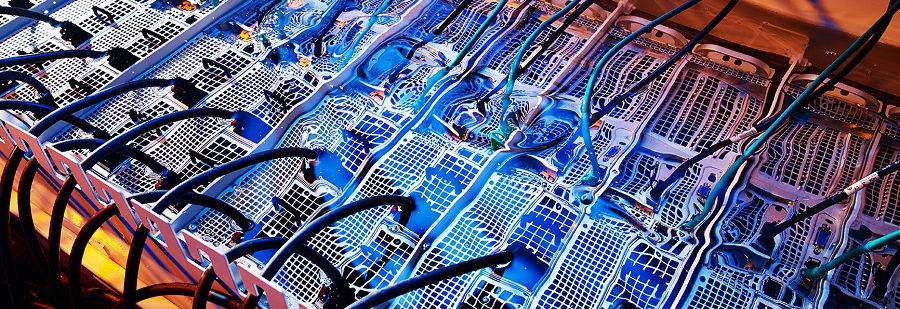

液浸方式

Asperitas、Submer、GRCなどの一部のメーカーでは、ラックを不活性液体の浴槽に完全に浸す方式を取っています。冷却する為のエネルギーを必要としないメリットはありますが、ラックの設計は全く異なり、ハードウェアの変更をする場合、サーバーやスイッチを浴槽から持ち上げて、一旦排水する必要があるため、メンテナンス時の作業が複雑になります。例えば現在、シュナイダーエレクトリック社の支援を受けているIceotope社の場合、ラック内のトレイにコンポーネントを浸漬するシステムを持っています。

コールドプレート方式

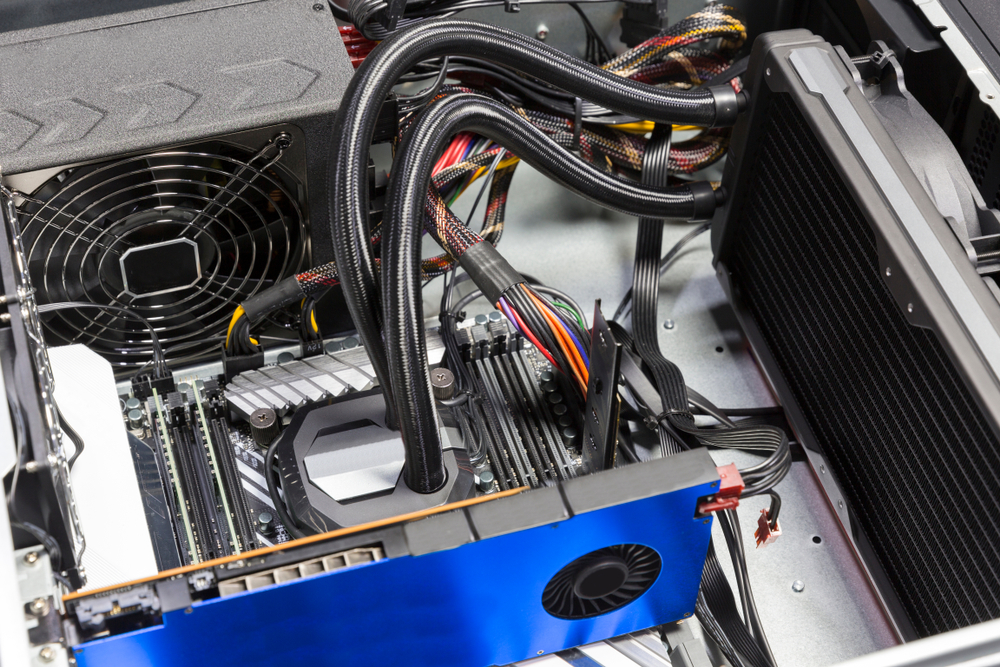

他には、エネルギーを大量に消費するコンポーネントのヒートシンクに配管を通し、液体を直接循環させるコールドプレート方式があります。これは、元々はコンピューターをオーバークロックさせたかったゲーマーによって考えられ、専用マシンを開発したことが起源です。

例えばCoolIT Systems社は、ラック内のIT機器用の液体循環システムを開発しましたが、これは特にスーパーコンピューターなどを対象としたニッチ製品です。ラックを変更し、循環システムを導入する必要があります。循環システムは、冷水をラックに流入させ、温水を流出させます。

また、 米Aquila社は、2017年にClustered Systems社と共同で、標準のOpen Compute Project( OCP )ラックに組み込まれた水冷式スーパーコンピューティングシステムAquariusを提供しました。

フランス北部では、OVHが独自の液体冷却方式を前述したラックで採用しています。以前はタペストリー、清涼飲料水、医療用品を製造していた工場を再利用したデータセンターを構築しています。同社の液体冷却方式では、施設を一つのシェルとして扱うことができます。建物レベルの空調を備え、ラック内のOVHスタックを必要に応じて液体冷却システムに接続します。

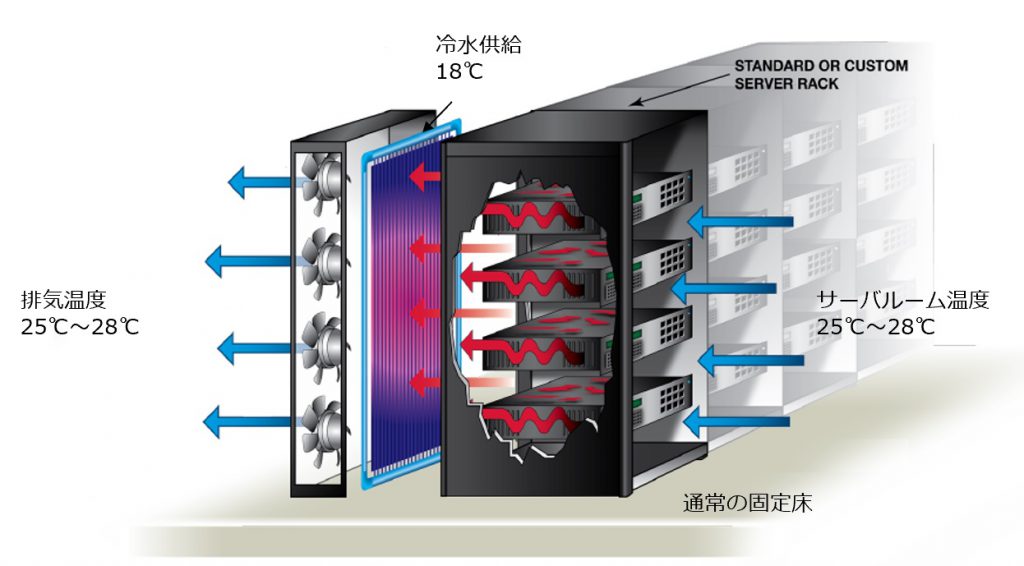

「当社のモデルは、既存の建物を購入し、当社の技術を使用できるように改造することです。」と、OVHの最高経営責任者 François Stérin氏はコメントしています。「これは、自主的な水冷システムを備えた弊社独自のラックを製造しているからこそ実現できています。また、ラックの背面に熱交換器ドア( リアドア冷却 )も採用しています。この構成は、ラックは建物に対してかなり独立していると言えます。」

柔軟性は市場の変化をもたらす、と Stérin氏は言います。「市場性を確かめるために、巨大な100MWのメガデータセンターを構築する必要はありません。1MWのデータセンターから始めて、市場がどのように機能するかを確認すれば良いのです。」

OVHはテクノロジーを前進させ、DCDに対し複数バージョンの将来コンセプトを示しました。OVHの技術者は、既存バージョンの冷却技術のメンテナンス手順を実演しました。

それはまるで手術室のように見えました。まず、冷却液を運ぶチューブを外科的にクランプで密閉し、次に パイプから取り外してからボードを取り外します。その後、ハードドライブがSSDに換装されました。

すでにこの設計は、 bayonet(銃剣型)ジョイントを使用する別の設計に取って代わっており、チューブを固定する必要なくボードを取り外すことができます。

ラックのリアドア熱交換器などでは、極端な液体冷却システムは利用できません。これは、空冷方式が有効な選択肢であるレベルでは効果的です。

OVHはこれと循環システムを組み合わせています。直接液体冷却( DLC )は、IT機器からの熱の70%を除去しますが、残りの30%も除去する必要があり、それをリアドア熱交換器によって除去しています。これは閉じたループ型システムであり、外部に排熱されます。

コンテインメントされたラック列を従来の冷却システムに接続し、セメント床に単独で配置される コンテナデータセンター は、今では非常に一般的です。Vertivなどのベンダーは、モジュール式のビルドを提供していますが、他のベンダーは独自の手法を提供しています。

興味深いベンダーの1つはGiga Data CentersのWindChillエンクロージャです。最近開設したノースカロライナ州ムーアズビルの施設ではシェル内に少しずつ機器の実装を進めていますが、1.15の PUE を達成していると主張しています。

ここでのアプローチは、ラックと共に空冷システムを構築し、大量の空気を引き込んで循環させています。

以上、様々な試みを紹介しましたが、誤った認識に惑わされないでください。しかしハードウェアの設計は常に変化しています。特にコロケーションデータセンターを構築する企業はこのような新しい設計思想を注視する必要があるでしょう。

Data Center Dynamics

コメント ( 0 )

トラックバックは利用できません。

この記事へのコメントはありません。