Nvidia、AIモデルトレーニング用最新ハイエンドGPU「H200」を発表

Nvidiaは、最新のハイエンドGPUであるH200 GPUを発表しました。

H200は141GBのHBM3eと4.8TBpsのメモリ帯域幅を備えており、これはH100の80GBのHBM3と3.5TBpsのメモリ帯域幅から大幅に改善されています。それ以外のGPUについては同一です。

NvidiaのハイパースケールおよびHPC担当バイスプレジデントのIan Buck氏は次のように述べています。「生成AIおよびHPCアプリケーションでインテリジェンスを創造するには、大容量かつ高速なGPUメモリを使い、膨大な量のデータを高速かつ効率的に処理する必要があります」

「業界をリードするエンドツーエンドのAIスーパーコンピューティング・プラットフォームであるNvidia H200は、世界で最も重要な課題を解決するために、より高速化を果たしました」

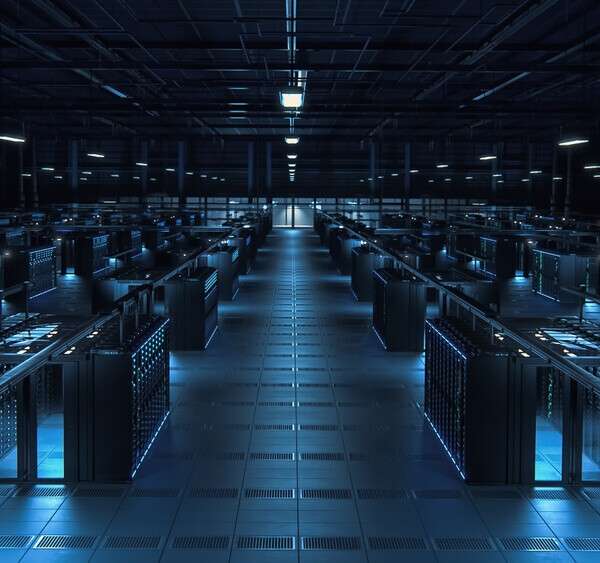

H200を搭載したシステムは、2024年第2四半期に出荷が開始される予定です。クラウドプロバイダーのAWS(Amazon Web Services)、Google Cloud、Microsoft Azure、Oracle Cloud Infrastructure、CoreWeave、Lambda、Vultrの各社は、来年からH200ベースのインスタンスを展開するとみられています。

このGPUは、4ウェイおよび8ウェイ構成のHGX H200サーバーボードで利用可能で、HGX H100システムのハードウェアとソフトウェアの両方と互換性があります。

ゆえに、ASRock Rack、ASUS、Dell Technologies、Eviden、Gigabyte、Hewlett Packard Enterprise、Ingrasys、Lenovo、QCT、Supermicro、Wistron、Wiwynnなどのサーバーメーカーは、既存のシステムをH200で更新することが可能となります。

H200は、先に発表された第2世代Grace Hopper Superchip(グレース・ホッパー・スーパーチップ) GH200の一部です。この製品は、H200と72コアのArmベースのGrace CPU、480GBのLPDDR5Xメモリを統合モジュールに組み合わせたものです。

この記事は海外Data Centre Dynamics発の記事をData Center Cafeが日本向けに抄訳したものです

コメント ( 0 )

トラックバックは利用できません。

この記事へのコメントはありません。