Google、Nvidia H100 GPUを26,000個までスケーリング可能なA3スーパーコンピュータVMを公開

ジェネレーティブAI向けに構築

Googleは、Nvidia H100 Hopper GPUを26,000個まで拡張可能な新しいスーパーコンピュータ仮想マシンを発表しました。

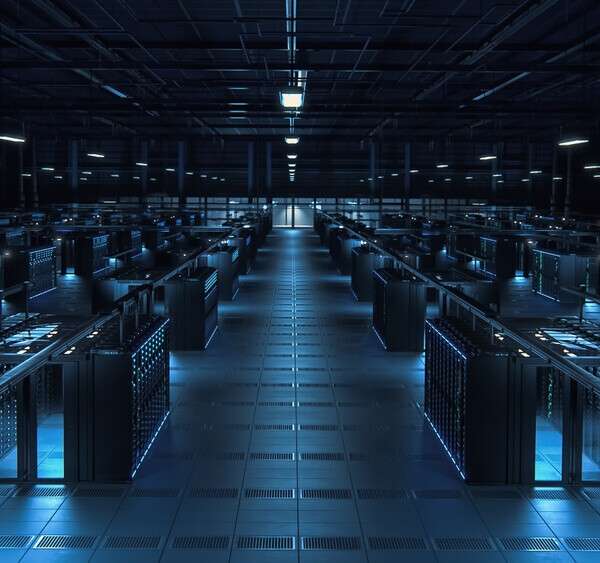

フルスペックのA3スーパーコンピューターは、最大26エクサフロップスのAI性能を発揮することが可能です。このシステムは、単一のデータセンターにあるのではなく、複数施設のリソースをプールしたものです。

1台のA3仮想マシンは、H100 GPUを8基、Nvidia NVSwitchおよびNVLink 4.0による3.6TB/sの2分割帯域幅、第4世代Intel Xeon Scalableプロセッサ、4800MHz DDR5 DIMMによる2TBのホストメモリを備えています。

また、GoogleのカスタムIPU(Infrastructure Processing Unit)を採用した最初のインスタンスであり、A2 VMと比較して10倍のネットワーク帯域幅を実現できるとしています。

Nvidiaのハイパースケール・ハイパフォーマンス・コンピューティング担当副社長Ian Buck氏は、「Google CloudのA3 VMは、次世代のNvidia H100 GPUを搭載しており、ジェネレーティブAI(生成AI)アプリケーションのトレーニングやサービスを加速させるでしょう」と述べています。

Nvidiaのハイパースケール・ハイパフォーマンス・コンピューティング担当副社長Ian Buck氏は、「Google CloudのA3 VMは、次世代のNvidia H100 GPUを搭載しており、ジェネレーティブAI(生成AI)アプリケーションのトレーニングやサービスを加速させるでしょう」と述べています。

「Google Cloudが最近ローンチしたG2インスタンスに続き、Google Cloudと協力して、目的に応じたAIインフラで世界中の企業の変革を支援できることを誇りに思います」

Googleは、このインスタンスはAIトレーニングを念頭に置いて設計していると述べています。「このようなワークロードの需要を考えると、画一的なアプローチでは不十分で、AI向けに特化したインフラが必要です」Google CloudのRoy Kim氏とChris Kleban氏はブログ記事の中でこのように述べています。

Googleは、自社のTPUチップもクラウド上で提供していますが、NvidiaのGPUは、生成AI市場の多くを占めています。

この記事は海外Data Centre Dynamics発の記事をData Center Cafeが日本向けに抄訳したものです。

コメント ( 0 )

トラックバックは利用できません。

この記事へのコメントはありません。