AWS、EC2上でNVIDIA の DGX Cloud及びGH200 SuperChipsを初めて提供へ

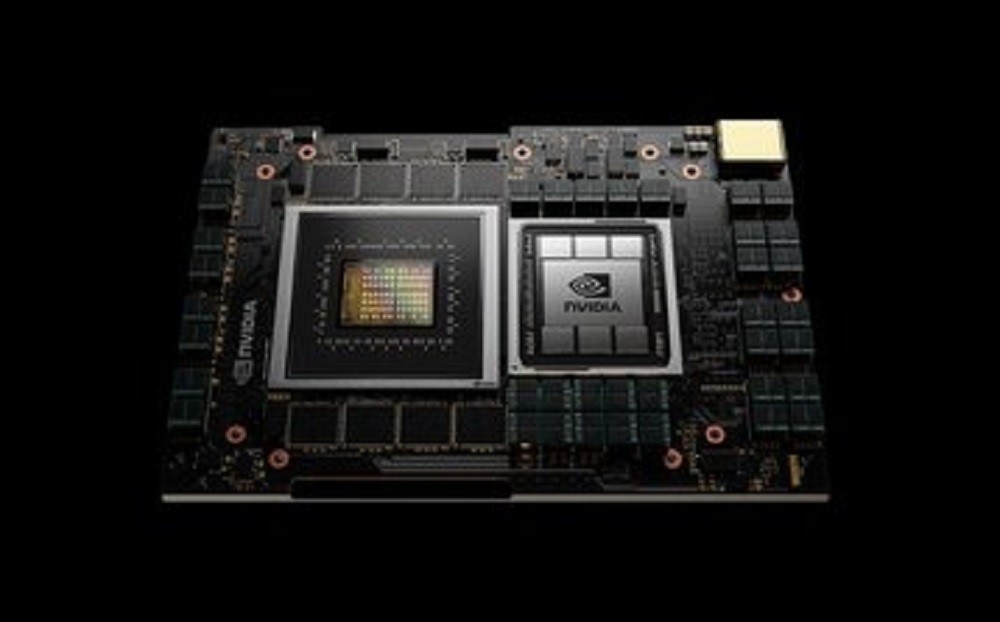

Amazon Web Services は、そのサービスで Nvidia’s GH200 Grace Hopper Superchips を提供する最初のクラウド企業になります。

同社は、Amazon’s EFA ネットワーキングに接続された Amazon Elastic Compute Cloud(Amazon EC2)インスタンスを介して、CPU と GPU を組み合わせたものを提供します。これは、AWS ニトロシステム仮想化と Amazon EC2 UltraClusters ハイパースケールサービスによってサポートされます。

AWS はまた、他のクラウドプロバイダー上で動作する NVIDIA 独自のサービスである Nvidia DGX Cloud 上で GH200 NVL32 チップを提供します。

AWS はまた、他のクラウドプロバイダー上で動作する NVIDIA 独自のサービスである Nvidia DGX Cloud 上で GH200 NVL32 チップを提供します。

ハイパースケーラーは基本的に Nvidia のサーバーをリースし、それをクラウド内部のクラウドとして展開します。これによりNvidia はそれを大規模 GPU スーパーコンピュータを求める法人に対し販売できるようになります。

Google、Microsoft、Oracle は以前、DGX Cloud をサポートすると発表していましたが、AWS は延期したと伝えられています。その他のハイパースケーラーは、ウェブ サイト上で DGX Cloud サービスの宣伝は行っていません。

「この DGX クラウドの発表を特別なものにしているのは、これが Nvidia Grace Hopperで駆動する初の DGX クラウドであるということだ」Nvidia のハイパースケールおよび HPC 副社長の Ian Buck氏はこのように述べています。

「これは、生成 AI 時代に向けた新しいラックスケール GPU アーキテクチャである」

NVL32 ラックアーキテクチャを備える GH200 は、クラウドサービス上の単一のインスタンスで最大の共有メモリを提供し、1 兆のパラメータを超える大規模言語モデルをサポートすると Nvidia は述べています。

さらにAWS re:Invent カンファレンスの中で、両社は、Nvidia の社内部門が使用する世界最大のクラウド AI スーパーコンピュータを AWS 上に構築する計画「Project Ceiba」についても発表しました。

この記事は海外Data Centre Dynamics発の記事をData Center Cafeが日本向けに抄訳したものです。

コメント ( 0 )

トラックバックは利用できません。

この記事へのコメントはありません。