現代の高負荷・高密度データセンターを考える【特集】

In-Row & コンテインメントシステム:

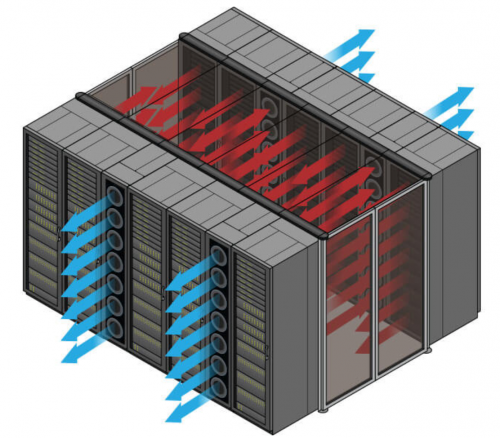

2000年代に入り、サーバー排熱量の上昇に伴い既存のCRACやCRAH空調では熱を取り除けるだけの十分な風量を担保できなくなってきたことで、データセンター内部の空調をできるだけサーバーラックに近い位置へと移動させられるようになりました。その中でも早期の段階から取り入れられたのが「 In-Row空調 」です。伝統的なCRACやCRAHシステムの変形型と見なすこともできますが、In-Row空調はサーバーラックの側面に空調を挟む従来と異なるデザインのものです。

In-Row空調 は、サーバー、ラックなど熱源のすぐ近くに空調機を設置することで、高密度サーバーやラックの冷却が可能となります。ホットアイルにたまった暖かい空気はIn-Row空調へと吸引され、冷水や冷凍機によって冷やされコールドアイルへと戻されます。サーバーの熱負荷へ対応するためには、一般的には12インチおよび24インチのIn-Row空調が必要となります。サーバーラックとIn-Row空調の割合は、高密度・高負荷環境になるほど等しくなっていきます。例えば、密度・負荷が低い場合は、サーバーラック5台に対して1台の12インチIn-Row空調で冷却可能なこともあれば、高密度・高付加環境においてはすべてのサーバーラックの間に24インチのIn-Row空調を設置することもあります。(写真:Aspen System)

In-Row空調はサーバーラックの間に導入することでIT機器の負荷に合わせた高効率な運用が可能になります。ただし、懸念事項として、一度CRACやCRAHを考慮して設計されたデータセンターのスペースは、安易にレイアウト変更ができるものではありません。特にラック貸し台数を基準に利益を上げているコロケーションデータセンターにとっては、In-Row空調を導入してラック台数が減ることで、売上が最低ラインを下回る可能性も生まれます。多くのエンタープライズおよびコロケーションデータセンターは、ITおよびインフラ双方の設計に気を配りながら、将来を見据え少しずつスケールアップ・スケールアウトできるようホワイトスペースの利用も促進しています。In-Row空調を大規模に導入する場合は上記のような点に気を配りながら管理をすればよいですが、例えば一部の高負荷エリアへ補助空調として利用する場合や、コロケーションデータセンターで一部顧客の高密度環境にのみ対応する場合などはシステム全体の統一性を保つのが難しく、導入設置チームにとっては大きな課題を押し付けられる可能性が生まれてしまいます。

ホットアイル ・ コールドアイル のいずれにしても、コンテインメントシステムとIn-Row空調については考える必要があります。サーバーラックの背面側に暖かい空気を溜める ホットアイルコンテインメント システムは、最も一般的に利用されています。建物への導入方法やアイルのレイアウトなどについては、これまで多くの人が議論を繰り返し、そして克服してきました。この記事で着目したいのは、「ホットアイルコンテインメントシステムがIT機器のパフォーマンスにどれだけの影響を与えるか」という、たびたび見過ごされる問題です。

熱力学の観点から考えると、ホットアイル側を封じ込めることで熱の温度が最大化され、In-Row空調へと高温の熱が吸収され、冷水や冷凍機によって熱が取り除かれます。この空気の流れがIn-Row空調のパフォーマンスと効率性を向上させますが、この考えは、最新の高密度IT機器が必要とするエアフローには対応できていません。キロワットあたりの空気流量はコンピューターメーカーだけではなくCPU・GPUメーカーによって異なり、おおよそ80cfm~130cfmとの流量が必要です。すべてではないにしろ、今日利用可能なIn-Row空調のほとんどが能力不足なため、結果としてシステムを導入した後になって、ホットアイル側で熱だまりが発生してしまうのが典型的な問題となっています。当たり前のように聞こえるかと思いますが、ここで重要なポイントは、「熱い熱をとどめる」ことにあります。しかしながら、それ以上に重要なのは、In-Rowシステムがホットアイルへ放出されるサーバー排熱を全て吸収できなければならないことです。少しでも吸収できない熱があると、サーバーファンへ圧力がかかります。熱だまりはサーバーファンのワークロードへ悪影響を及ぼすだけでなく、チップの過熱を引き起こします。熱だまりによって、CPUやGPUなどのチップはダウンしたり、計算能力が制御されたりと、設計したパフォーマンスを発揮できなくなるようになります。導入後の修正が不可能ではないにしても、これはかなり困難な状況といえるでしょう。高密度環境にコンテインメントシステムとIn-Row空調を導入する際は、事前にMEPチームや運用チーム、可能であれば顧客も交えて空調システム全体に関わるデータを一度共有しあうことが重要です。

アクティブリアドア熱交換器:

アクティブ型リアドア熱交換器( ARDHx )は、HPCクラスタおよび高密度サーバーラックを製造し使用する人々の間で人気が高まっています。 リアドア冷却 は、インフラ基盤をほとんど変更せずにサーバーラックから熱を100%除去できるため、システム効率と利便性の向上をもたらします。

ARDHxは一般的にラックの仕様には依存せず、業界標準であるサーバーラックの背面ドアに直接取り付けられるものです。ARDHxはラックから熱を除去するために、高性能ファン・冷却水を並行して利用しています。ドアに取り付けられている電子整流(EC)ファンがサーバーのファンと連携しながらCFMを調整して、ラックから100%熱を除去することが可能となります。

ARDHxは、通常水温13~23度の水またはグリコール混合物を使用します。13~23度の液体は、ほとんどのデータセンターで容易に入手可能ですが、そうでない場合は、冷水プラント、冷却塔、乾燥流体クーラー等を組み合わせた閉回路冷却システムで生成できます。ARDHxは、ルームレイアウトなどのインフラへほとんど手を加えず、かつ周辺のコンピュータラックにも影響を与えずに、コロケーション施設や従来のデータセンターなどの既存コンピュータルームに高密度サーバーラックを設置することができます。(※写真は、米国Motivair社製ARDH:ChilledDoor)

アクティブ型リアドア熱交換器は、コンピュータラック1台につき最大75kWを除去することができ、クラスタが何回か更新できるような大規模なスケールを提供します。アクティブ型リアドアはサーバーラック内部の温度および外部室温を監視、一定ににする機能を保証しており、所有者にとってはそれもメリットとなります。

サーバー製造者による最近の実験では、 ARDHx を導入すると、ARDHxファン自体の消費電力を最小限にコントロールするだけでなく、ラック内のサーバーファン消費電力(コスト)も削減されることがわかりました。直感的には想像しづらいですが、ARDHxファンがサーバーファンをサポートし、高密度負荷でもエネルギー消費を抑え、パフォーマンスを向上させることが徹底した分析によって明らかになりました。テストでは、ハードウェアのパフォーマンス向上だけでなく、サーバーの寿命も延びたことがわかりました。

ARDHはラックの背面に完全にアクセスできるだけでなく、上下両側からの水供給に対応した設置ができるため、上げ底床の使用に関わらず新規または既存の施設に導入できます。

総論:

高性能コンピュータシステムの消費電力が増加し続けるにつれて、それを冷却する方法がますます重要になってきています。HPCと高密度サーバーを広範囲に使用するアプリケーションが今後継続的に増えていくと、以前は国立研究所や大規模な研究施設での使用に限られていたこの領域も、従来型のデータセンターでも運用されるようになり、全体的なデータセンターのPUE通信に集中できるようになります。

今回紹介した、液浸冷却、オンチップ/ダイレクトチップ型冷却、アクティブ型リアドア空調は、現在利用可能かつ信頼性の高いHPC・高密度サーバーシステムの冷却手法です。今後、建物の冷却インフラ基盤、将来の更新計画および予算内で機能する効率的で実用的なシステムをこの中から選択しなければなりません。このような高性能コンピュータを冷却するための技術および設計計画は、コンピュータシステムの購入前または並行して行われるべきでしょう。なぜなら、冷却システムそのものが、コンピュータ性能の最適化を担保するための重要要素として認識されているからです。

Motivair社製アクティブ型リアドア空調 – ChilledDoor

お問い合わせは株式会社DC ASIAへ

– Data Center Dynamics

– 原文はこちら

コメント ( 0 )

トラックバックは利用できません。

この記事へのコメントはありません。