Googleが第7世代TPU「Ironwood」を発表

256チップと9,216チップの両方の構成で提供

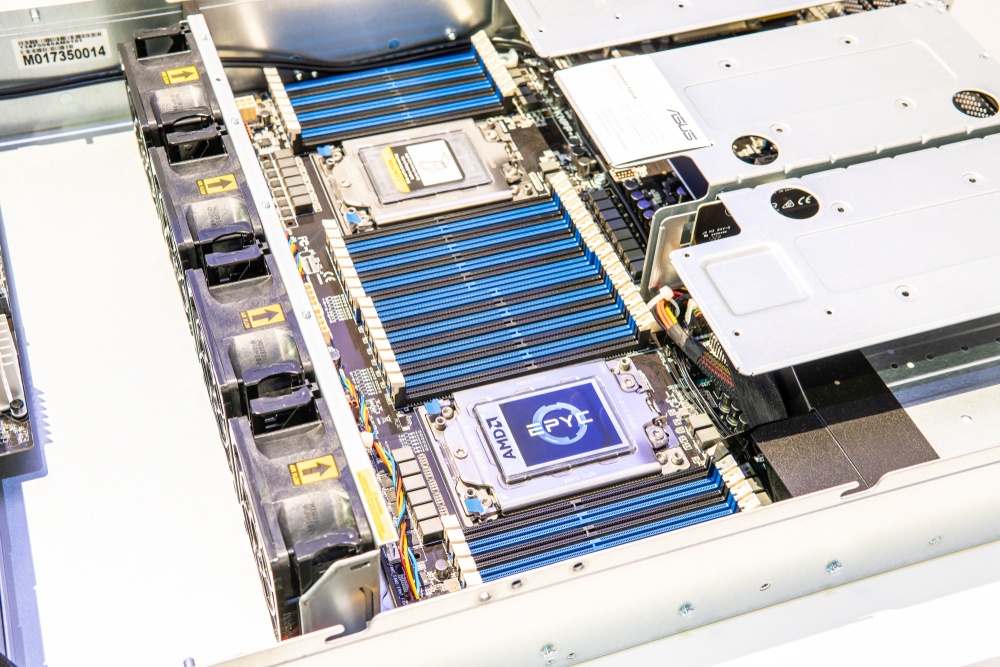

Googleは、第7世代のテンソル処理ユニット(TPU)「Ironwood」を発表しました。

ラスベガスで開催された同社のイベント「Next ’25」で発表されたこのTPUは、推論専用に設計された初のTPUだとGoogleは述べています。

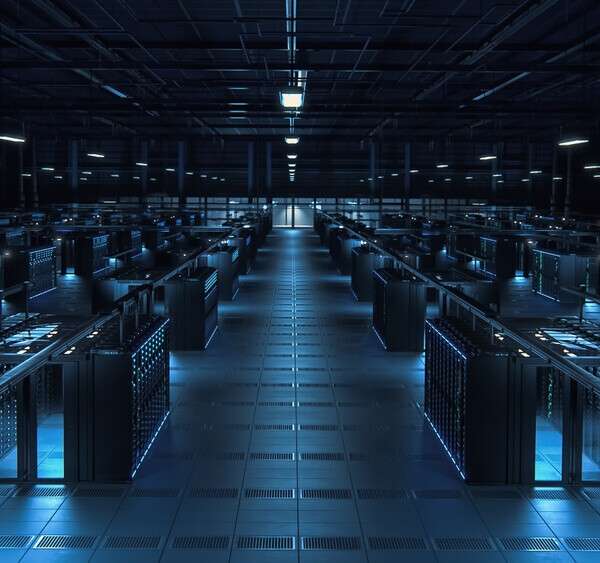

Googleが「生成AIの次の段階」と呼ぶものの計算要件をサポートするために構築されたIronwoodは、AIのワークロード需要に基づく2つの液冷サイズ、256チップ構成と9,216チップ構成があります。

Googleによると、個々のチップのピーク演算性能は4,614テラフロップスで、9,216チップに拡張した場合、各ポッドの合計演算性能は42.5エクサフロップスになるとのことです。

しかし、El Capitanの性能はFP64精度で測定されており、GoogleはIronwoodの計算性能を算出するためにFP8精度ベンチマーク、つまり8ビット精度の計算を使用したようです。

AIの性能はFP8で測定されますが、従来の計算性能は倍精度計算で測定され、大規模システムの業界標準であるFP64としても知られています。

その結果、100ペタフロップスのFP64性能を誇るシステムは、例えば100ペタフロップスのFP8性能を達成したシステムよりも強力になります。

DCDはGoogleに問い合わせをしているところです。

Ironwoodはまた、1チップあたり192GBの7.4Tbpsの高帯域幅メモリ(HBM)を提供しており、これはGoogleの第6世代TPU「Trillium」の6倍に相当します。さらに、双方向のチップ間相互接続(ICI)帯域幅は1.2Tbpsで、Trilliumの1.5倍に相当します。

発表に先立ち行われた記者説明会で、MLシステム・クラウド担当副社長兼GMのAmin Vahdatは、Ironwoodは、2018年の最初のクラウドTPUより30倍近く電力効率が向上し、Trilliumの約2倍の効率であると述べました。

そして、「第7世代のTPUであるIronwoodを発表できることを嬉しく思います。これは、もはやモデルのデータビットではなく、学習後のモデルがデータに対して何ができるかという推論の時代へとお客様を導くものです。」とコメントしています。

さらにGoogleは、Ironwoodの立ち上げに伴い、同社のネットワークを「新たな高み」へと押し上げるとしており、新しい400G Cloud InterconnectとCross-Cloud Interconnectは、同社の100G Cloud InterconnectとCross-Cloud Interconnectの最大4倍の帯域幅を提供するとのことです。

Hyperdisk Exapoolネットワークブロックストレージは、最大1エクサバイトのブロックストレージ容量をプロビジョニングできるようです。

Amin Vahdatは、次のように述べています。「10年以上前、Googleは自社サービスのためにTPU開発への投資を開始し、スケールと効率の可能性のフロンティアを押し広げました。業界として、この8年間で、トレーニングやサービングモデルに対する需要は前年比10倍、つまり1億倍になっています。」

この記事は海外Data Centre Dynamics発の記事をData Center Cafeが日本向けに抄訳したものです。

コメント ( 0 )

トラックバックは利用できません。

この記事へのコメントはありません。