Nvidia、データセンター向けArm CPU「Grace」を発表

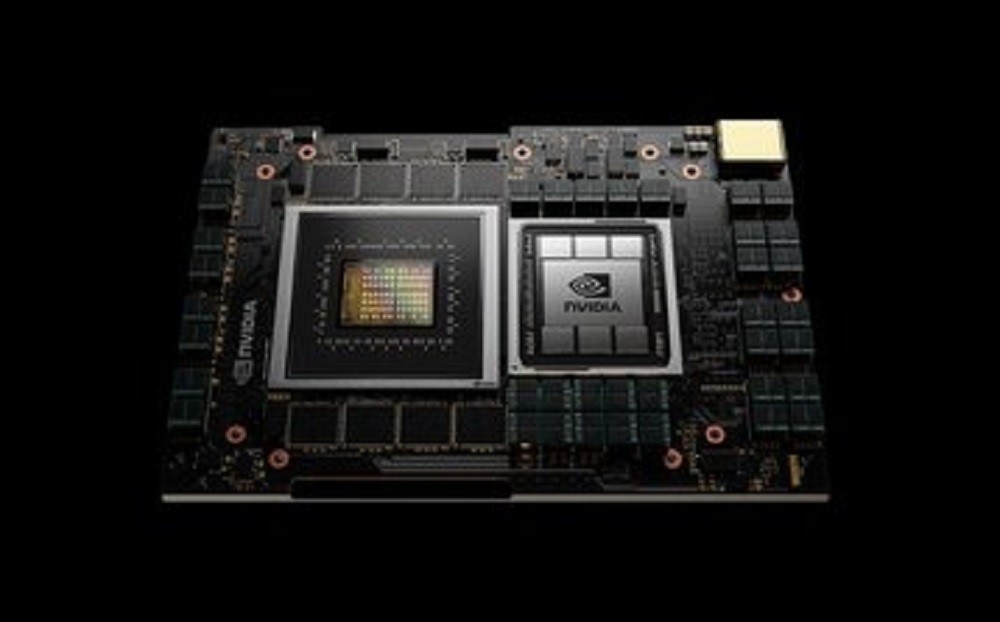

Nvidiaは、独自のArmベースのCPU、「Grace」を発表しました。

Graceは、大規模なニューラルネットワークのワークロードに特化して設計されたデータセンターサーバ向け製品で、2023年からNvidia製品に搭載される予定です。

グレース・ホッパー氏にちなんで名付けられたこのチップは、NvidiaがArmを400億ドルで買収しようとする動きの発表となりました。

データセンター向けCPU市場にArmが参入する最新の兆候

「最先端のAIとデータサイエンスは、今日のコンピュータ・アーキテクチャの限界を超えて、考えられないほど大量のデータを処理している」Nvidiaの創業者でありCEOを務めるJensen Huang氏はこのように述べています。

「Nvidiaは、ライセンス供与されたArmのIPを用いて、Graceを巨大スケールのAIやHPCに特化したCPUとして設計した。GPUやDPUと組み合わせることで、Graceはコンピューティングのための第3の基盤技術を提供し、AIを進化させるためにデータセンターを再構築する能力を与える。Nvidiaは今や3チップ( CPU 、 GPU 、および DPU を擁する)企業である」

同社は、Grace CPUとNvidia GPUのコンボは、GPUとAMD CPUを使う現行のDGXシステムの10倍の速度を期待していると述べています(もちろん、2023年までにはAMDのCPUも高速化されるでしょうが)。

NvidiaはGraceを同社のGPUとの組み合わせでのみ販売し、2つのチップタイプを緊密に結合していくと見られています。CPUとGPUはNVLink 4で接続され、最低でも900GB/秒以上の累積帯域幅を確保するといいます。

Graceの具体的な設計や性能に関する詳細はまだ公表されていませんが、同社はArmの次世代CPUコア「Neoverse」を採用するとしています。

スイス国立スーパーコンピューティングセンター(CSCS)と米国エネルギー省ロスアラモス国立研究所は、いずれも2023年にGrace CPUを搭載したスーパーコンピュータの構築を計画しています。

どちらのシステムもHPE Crayによって構築される予定です。CSCSのスパコン「Alps」は、20エクサフロップスのAI性能(Linpackではない)を持つと予想されており、これはAIに特化した世界最速のスパコンとなります。

ロスアラモスのシステムについては、「リーダーシップクラス」になるということ以外、ほとんど詳細は開示されていません。

ロスアラモス国立研究所所長のThom Mason氏は、次のように述べています。「メモリの帯域幅と容量の革新的なバランスを備えたこの次世代システムは、我々の研究所のコンピューティング戦略を形作るだろう。Nvidiaの新しいGrace CPUのおかげで、これまで以上に大規模なデータセットを用いて、ハイ・フィデリティ(高忠実度)な3Dシミュレーションや分析を用いた高度な科学研究を行うことができるようになるだろう」

Data Center Dynamics

コメント ( 0 )

トラックバックは利用できません。

この記事へのコメントはありません。