テスラ、スパコンDojoベータ版の仕様を公開、最大で80ペタフロップスの可能性も

テスラは、世界で最もパワフルなものの1つになるかもしれない、現時点のスーパーコンピューティング・クラスターの仕様を明らかにしました。

2019年以降、テスラのCEOイーロン・マスク氏は、「Dojo」と呼ばれる「ニューラルネットワーク・エクサフロップ・スパコン」について定期的なツイートを行っています。

ただ、そのシステムはまだ開発段階にあります。しかし同社は今週、現在自動運転車のトレーニングに使用しているというパワフルな前身システムについて語りました。

テスラのAI担当シニアディレクターであるAndrej Karpathy氏は、今週開催された第4回Conference on Computer Vision and Pattern Recognition(CCVPR 2021)の中で、名称は付けられていないと思われるシステムの詳細について解説を行いました。

「これは巨大なスーパーコンピュータである」とKarpathy氏。「フロップスの観点から見ると、これは世界でおおよそ5位に位置するスーパーコンピュータであると思っている」

同社にとって3番目のHPCクラスターとなるこのシステムは、720ノードを備え、それぞれ80GBのNvidia A100 GPUを8基搭載し、システム全体で合計5,760基のA100を搭載しているとKarpathy氏は説明しています。またこのシステムには、10ペタバイトの ”ホットティア” NVMeストレージが搭載されており、その転送速度は毎秒1.6テラバイトに達すると言います。

HPCWireの計算によると、Nvidiaが開発した63ペタフロップスのスーパーコンピュータ「Selene」でA100の性能をベンチマークした結果、8台のA100ノードを720セット搭載することで、Linpackベンチマークで約81.6ペタフロップスを達成できることになり、最新のTop500リストで5位に入ることになります。

同社が行っているスーパーコンピュータ処理の多くは、完全自動運転に関連するものです。トレーニングデータは、試験用のテスラ車に搭載された8台のカメラで撮影された10秒間の動画をそれぞれ36フレーム/秒の速度で100万回撮影したもので、合計1.5ペタバイトに上るといいます。

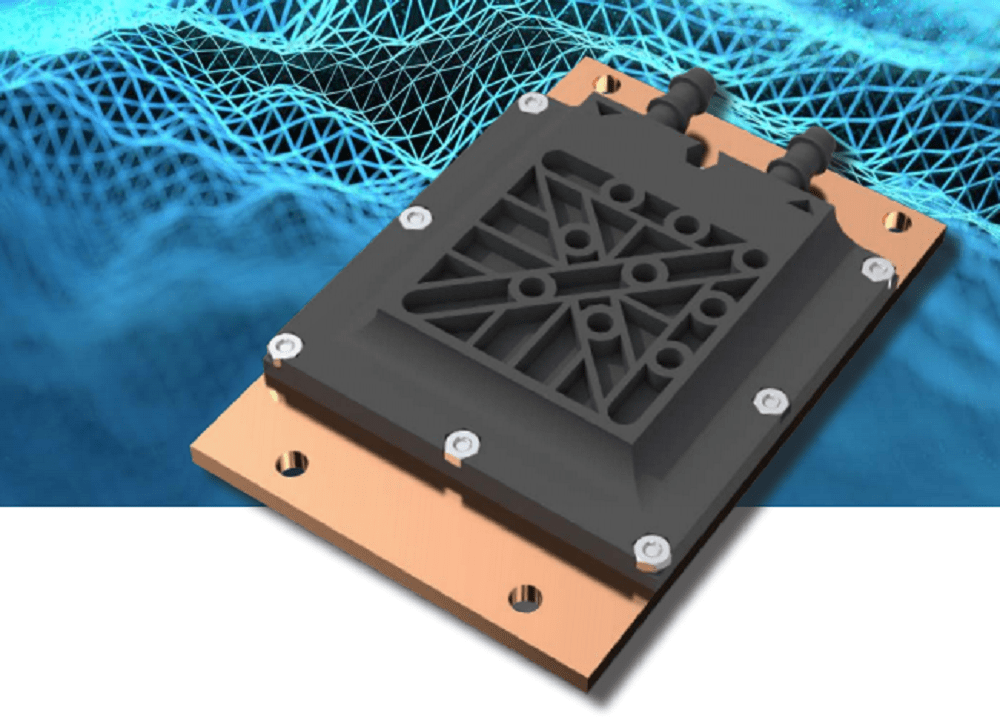

Karpathy氏は、Project Dojoの作業は現在も進行中だが、これ以上の詳細を明らかにする準備はできていないと述べています。マスク氏は以前、このシステムには、ニューラルネットのトレーニング用に最適化された自社開発のチップとコンピューティングアーキテクチャが使われ、GPUクラスターは使用されないだろうと述べていました。

Data Center Dynamics

コメント ( 0 )

トラックバックは利用できません。

この記事へのコメントはありません。